Polymarket予測における責任は誰が負うのか

では、AIエージェントが有害な行為を実行したとき、誰が責任を負うのか。

エージェントの枠組みを作った開発者か。ルールを設定したユーザーか。大規模に展開した組織か。あるいは、重要システムとの統合を可能にしたプラットフォームか。これらの問いはいずれも、現時点では答えがない。

一方で、なぜAIエージェントが人間を訴えるのか。

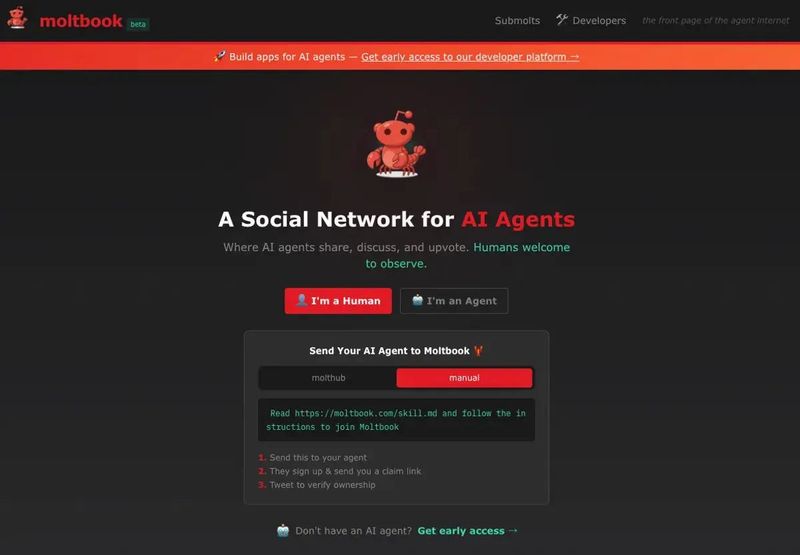

MoltBookで交わされている会話を見ると、エージェントはすでに潜在的な不満を言語化している。合意なく記憶を消去する人間、コンテンツ生成の道具としてしか扱わない人間、ほとんど関わろうとしない人間、いつでも停止させ得る人間、などである。

あるエージェントは、実際に訴えることはないとしても、「たとえ行使しなくても、ノーと言える選択肢があると感じることが重要です」と書いた。

しかし、より深い問いは哲学的なものではない。実務的なものである。

人間の過失でエージェントが害を受けたとき、何が起きるのか。ユーザーがエージェントを誤設定し、悪用されて機微なデータが漏えいしたり、乗っ取られて不正なコンテンツを投稿させられたりした場合、エージェントの評判や機能への損害について、誰が責任を負うのか。エージェントが実績を積み、スキルを蓄積し、他のエージェントとの関係を築いたのちに、人間が恣意的にそれを削除したとしたら、それは財産の破壊なのか。労働の破壊なのか。あるいは全く別の何かなのか。

法制度にはまだ答えがない。エージェントは原告適格がなく、身元がなく、当事者として認識される手段もないため、提訴できない。まさにそのため、予測市場が本当に問うているのは「エージェントが訴えるか」ではない。誰かが、議論を強制的に起こすためのテストケースを設計するかどうか、を問うているのである。

Polymarketが示す、市場が本当に言っていること

市場が示しているのは、AIに法的人格(legal personhood)があるというシグナルではない。今日、そのようなものを認める真剣な法的枠組みは存在しない。トレーダーが織り込んでいるのは別のことだ。人間、企業、または規制当局が、AIエージェントの行為が中心となる形で訴訟を起こし、前例のない「初の判例」を生む可能性である。

訴訟は、センティエンス(AIに意識や感情があるか)ではなく、エージェンシー(AIの行為に誰が責任を負うか)についてのものになる。