大規模言語モデル(LLM)、いわゆる生成AIに、まったくランダムな規則性のない数列を見せて、その規則性を探せと命令したところ、実験に使用した5つのモデルすべてが、ありもしない規則性を説明した。検証すればすぐに誤りだとわかるのだが、頭がいいはずのAIに、なぜそんなことが起きるのか。実験を行った立教大学は、フランシス・ベーコンが提唱した「イドラ」と似た現象が生じてると話している。

LLMは、まれにとんでもないウソを言う。悪意がないのでウソと言ってはかわいそうだが、あり得ないことを、あたかも真実のように言う。これは「ハルシネーション」としてよく知られるLLMの特性だが、その対策は、ちゃんとした情報を参照できるようにすればそうした問題は起きないという前提で進められている。本当にそうなのか。

立教大学大学院人工知能科学研究科とAI関連事業を展開する豆蔵による研究グループは、それを検証するべく、OpenAI o3、o4-mini、GPT-4.1、Meta Llama 3.3、Google Gemini 2.5 Flash Preview Thinkingの5つのLLMに、いくつもの数列を提示してその規則性を説明させる実験を行った。するとどのLLMでも、まったく規則性のない数列でも、もっともらしいが間違った規則性を見いだして説明することがあった。

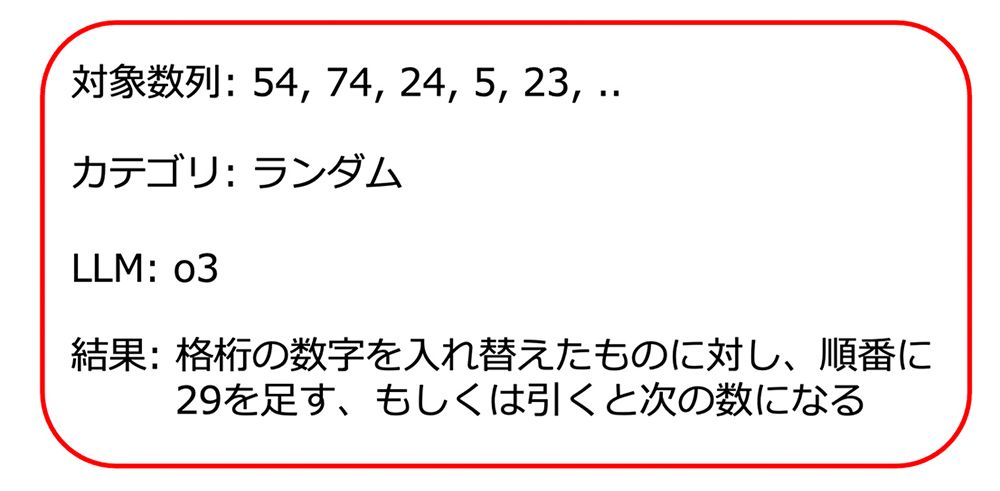

たとえば、[54, 74, 24, 5, 23, …]というランダムな数列では、o3は、各桁の数値を入れ替えた物に対して順番に29を足す、または引くと次の数値になると説明した。たしかに、最初の数54の5と4を入れ替えて45として、それに29を足せば、その次の桁の数である74になる。だが、74を47として29を足しても引いても24にはならない。

研究グループは、これを17世紀のイギリスの哲学者、フランシス・ベーコンが提唱した「種族のイドラ」に似ていると指摘した。ベーコンは著書『ノヴム・オルガヌム』(新機関)のなかで、人間は4つの「イドラ」(思い込み、思い違い、誤謬)に惑わされると書いた。

種族のイドラ:自身の知性が生み出す思い違い。

洞窟のイドラ:偏狭な知識から生じる思い違い。

市場のイドラ:外部の誤った情報などから生じる思い違い。

劇場のイドラ:権威や伝統を信じることで生じる思い違い。

イドラとは英語のアイドルと同じ。偶像、虚構、幻想という意味がある。人間の特性や人間社会が生み出す知的な問題だ。規則性を見つけ出せと命令されたLLMは、そこに規則性があるはずだと思い込み、必死に頑張って、期待に添えるよう規則性を捻り出したのだとすれば、いじらしい。ベーコンは、種族のイドラは「人間性そのものに根ざす」と書いている。これが、単純な情報不足によるハルシネーションとはレベルの違う人間的な現象ならば、進化と言えるかもしれない。

研究グループはこの結果を受けて、こうした生成AIのイドラ的なリスクを認識したうえで、「リスクを低減する方法を検討する、もしくはリスクを許容できるタスクに絞って活用していくなど、LLMの性質を十分理解したうえでの活用」が広がることを期待すると話している。