日本語対応の精度は? 英語による講演会や記者会見のリスニングにも役立つ

先に触れた「Safariの翻訳機能」のように外国語のテキストを「読む」場合には、翻訳結果が長めのテキストになっていても大きな支障はない。ところが、イヤホンやスピーカーを使って「翻訳を音声で聞く」となれば話は別だ。

ホァン氏は、日本語を含む多くの言語でライブ翻訳を実現するために最も難しかった点として、可能な限り「まとまりのある翻訳」を、テンポ良く途切れさせず出力して提示することだったと振り返る。言語によっては、翻訳元の言語に比べて、同じ意味を表すフレーズを表す言葉の数が異なっている場合もある。すべての言語ペア(翻訳元と翻訳先)で、できるだけ速く言語を出力できるように、各言語をチューニングすることに腐心したという。

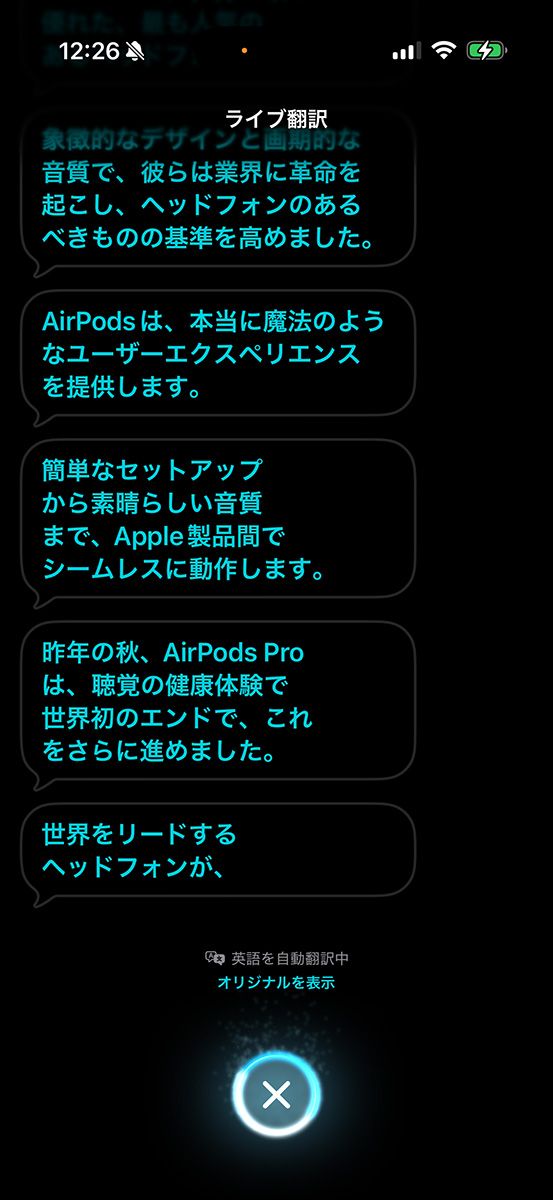

筆者もiOS 26.1を入れたiPhone AirとAirPods Pro 3の組み合わせで、9月にアップルが実施した新製品発表会の動画を再生しながら、英語から日本語へのライブ翻訳を試した。話者の長めのスピーチは文節単位で細切れにしながら、逐次翻訳される。原語によるスピーチから1つ、2つ文節が遅れるぐらいのスピード感だ。スピーチに対して翻訳が遅れないように、1つの文節に多くのワードが含まれる場合は翻訳音声が1.5倍ぐらいの早口で再生される。

ライブ翻訳の精度については元となるソースの内容に依存するところもありそうだ。例えばアップルの発表会はとてもキレイな日本語に翻訳されたが、YouTubeでカジュアルな内容の英語のコンテンツを再生しながら試したところ、奇妙な翻訳もあった。それでも、iPhoneの画面に表示されるテキストを読みながらであれば、内容は大づかみに理解できる。筆者がまったくわからない外国語だった場合、ライブ翻訳があればかなり心強いと思う。

ライブ翻訳中のAirPodsは、今この瞬間に話している話者が「ユーザー」なのか、あるいは「対面して話す人物」なのかを自動で判別できる。さらにANC(アクティブノイズキャンセリング)機能を起動して、対面して話す相手の生声を少し減衰させることも同時に行っている。これはユーザーが翻訳音声の方に集中できるようにするためだ。「アクティブノイズキャンセリングの技術が、AirPodsのライブ翻訳機能の快適さを支えている」とホァン氏は語る。ゆえにライブ翻訳機能に対応するAirPodsは、アクティブノイズキャンセリングを搭載するモデルに限られている。